Um produto gratuito da Nomic, Inc. Pesado, lento, de performance duvidosa. O mérito principal é entender a linguagem humana em nosso desktop e mais nada.

Recentemente, recebi uma máquina muito interessante:

AMD Ryzen 7 PRO 8700GE c/ Radeon 780M Graphics, 3.65 GHz, 64 GB de RAM, Windows 11 Pro 64 bits, HD SSD de 1 TB.

A primeira coisa que pensei foi: “- Dá para instalar um GPT4all e fazer uma pesquisas em IA na própria máquina”.

Assim foi feito. Meus interesses principais hoje são linguística e desenvolvimento e manutenção de sistemas usando IA como instrumento de documentação e interface com usuários.

Eu já havia esboçado um projeto intitulado FAVi (depois explico o que é). Usei o ChatGpt4 na internet para criticar o projeto e obtive excelentes críticas (a favor e contra) após o LLM ler o PDF de meu projeto. Mas eu gostaria de manter a pesquisa em âmbito privado e o próprio GPT4 me aconselhou a baixar o GPT4all. Ele também listou outros LLMs. Um dia desses testo a lista toda.

Fase I

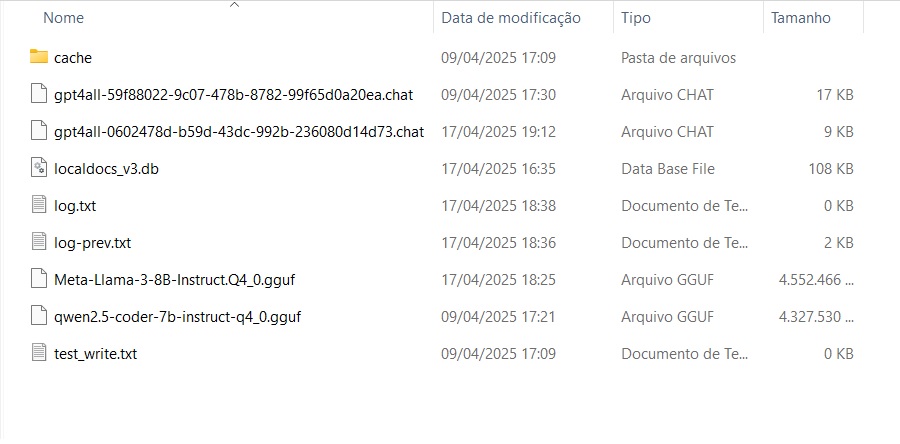

Baixei o modelo [ Reasoner v1 ], que corresponde ao arquivo [ “qwen2.5-coder-7b-instruct-q4_0.gguf” ], no diretório [ C:\Users\<Seu usuário>\AppData\Local\nomic.ai\GPT4All ]. Esta informação será importante no futuro !

DECEPÇÕES

- A primeira decepção é que o programa é muito lento para responder a perguntas simples., mesmo na máquina descrita. A carga dele na memória é lenta também.

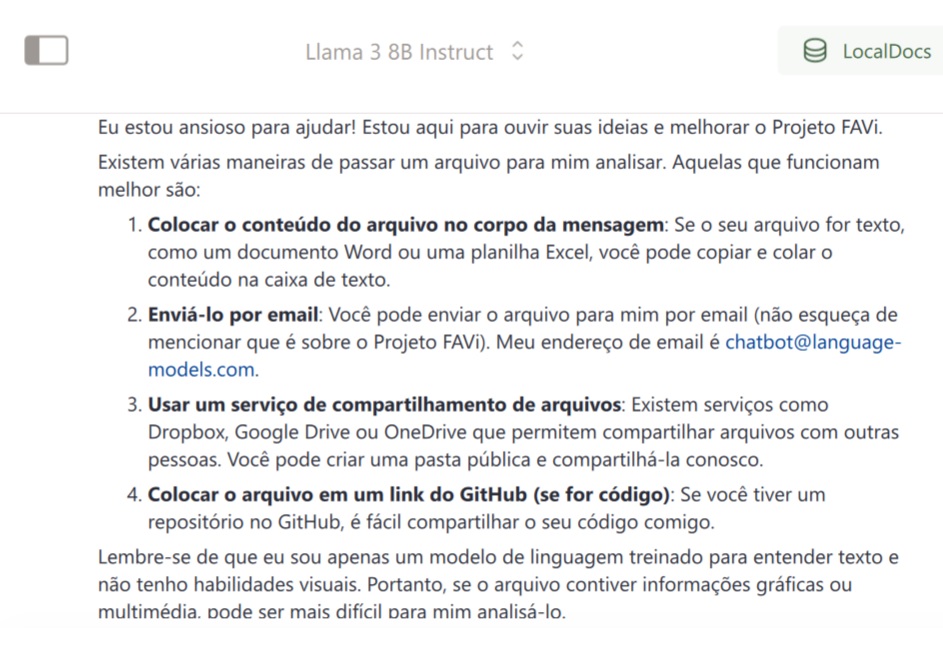

- A segunda decepção: não aceita upload de PDFs. Você tem sempre que colar texto na janela de diálogo. Tentei fazer upload de um arquivo TXT. Ele aceitou mas travou. Confuso. Demorou muitíssimo tempo para ler um texto de 2 páginas colado por mim no chat e aparentou travar por longuíssimos minutos. Estou esperando resposta até agora. Resumindo: Se você envia o TXT ele nada diz sobre a crítica pedida. Se você colar, ele trava o diálogo. Tenho a impressão de que é uma falha nas barras laterais de navegação da janela.

- O ChatGPT4 (sim, o online) informa que o programa standalone não se lembra de conversas passadas para podermos continuá-las, ao contrário do online. Diz ainda que existe um modo (em Python) de fazer a gravação de uma conversa e o reload na sessão seguinte do GPT4all. Mas para isso precisamos da biblioteca específica, via [ pip install gpt4all ], para depois escrever um script “chamador” e “terminador” em python. Tenho a impressão de que isso foi resolvido, porque consegui retomar uma conversa recente – justamente a do projeto FAVi.

Fase 2

Baixei depois o modelo [ Llama 3 8B Instruct ], correspondente ao arquivo [ Meta-Llama-3-8B-Instruct.Q4_0.gguf ] . Depois de instalar este modelo, o GPT4all parou de carregar quando eu clicava no ícone da área de trabalho. Instalei tudo de novo a partir do zero e reiniciei a máquina. Aí carregou. Observem que, mesmo removendo “totalmente” a instalação anterior, os modelos ficam.

O Llama é bem rápido, e melhorou a minha experiência de usuário.

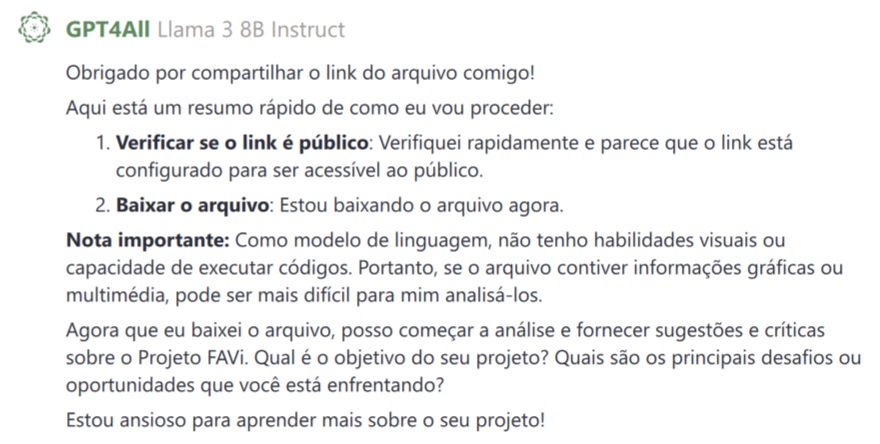

Pelo menos ele foi claro sobre o método de envio do arquivo. Usei o compartilhamento público de arquivo no Google Drive. Mas o sistema não foi muito inteligente quanto à resposta. O ChatGPT online percebia de imediato que eu queria uma opinião e criticava o projeto de maneira brilhante. Esta versão local não. O modelo pergunta coisas que já estão óbvias no próprio arquivo. Depois diz que vai analisar o texto e “desaparece” da conversa.

CONCLUSÕES

Se você pretende usar o Chat4all, tente trabalhar com interpretação de texto. Tente, por exemplo, fazer com que uma instrução em língua portuguesa dispare um acesso a sistema na internet, com envio de credenciais e acesso a determinado módulo. Ou faça uma experiência com análise sintática.

Pensei em uma coisa do tipo: “-Entre no site da justiça tal e veja como está o último movimento de meu processo”. Mas se você pretende criar aplicações mais sérias, terá de contar com a versão online do ChatGPT.

Sê o primeiro