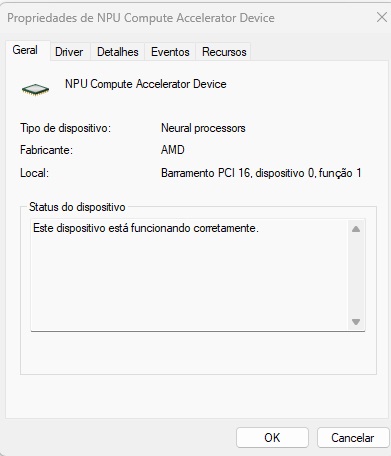

Em algumas máquinas novas no mercado já podemos notar a presença de NPUs – Processadores Neurais.

Perguntamos ao ChatGPT para que serve uma NPU.

Um NPU (Neural Processing Unit) – Computer Accelerator Device é um tipo de processador especializado projetado para acelerar tarefas de inteligência artificial (IA) e aprendizado de máquina (ML). Ele é otimizado para realizar operações de redes neurais artificiais, oferecendo desempenho superior em relação às CPUs e GPUs para esses tipos de cálculos.

Principais Características de uma NPU

- Otimização para IA: Projetada especificamente para cálculos matriciais e operações de deep learning.

- Eficiência energética: Consome menos energia do que uma GPU para tarefas de inferência e treinamento de modelos de IA.

- Processamento paralelo massivo: Pode executar várias operações simultaneamente, tornando-a ideal para redes neurais convolucionais (CNNs), redes recorrentes (RNNs) e outras arquiteturas.

- Baixa latência: Reduz o tempo de resposta em aplicações como reconhecimento de imagem, processamento de voz e visão computacional.

Aplicações

- Smartphones e dispositivos móveis: Muitos celulares modernos usam NPUs para otimizar processamento de IA em câmeras, assistentes virtuais e reconhecimento facial.

- Data centers e servidores: Melhoram o desempenho de cargas de trabalho baseadas em IA, reduzindo custos operacionais.

- Automação e robótica: Usadas para visão computacional e controle autônomo em robôs e veículos autônomos.

Exemplos de NPUs

- Google TPU (Tensor Processing Unit): Usado no Google Cloud para acelerar modelos de IA.

- Huawei Ascend: Presente em dispositivos móveis e servidores de IA.

- Apple Neural Engine (ANE): Integrado nos chips da série A e M da Apple para otimização de IA em iPhones e Macs.

- Intel Movidius: Projetado para visão computacional e deep learning em dispositivos de borda.

NPUs estão se tornando cada vez mais comuns, pois permitem que dispositivos executem IA de forma mais eficiente, sem depender tanto de processamento em nuvem.

Principais Bibliotecas e Frameworks para NPUs

Para programar uma NPU (Neural Processing Unit), geralmente é necessário usar bibliotecas e frameworks específicos, pois esses aceleradores de IA possuem arquiteturas especializadas que diferem de CPUs e GPUs convencionais.

Aqui estão algumas bibliotecas e ferramentas usadas para programar diferentes NPUs:

1. Google TPU (Tensor Processing Unit)

- TensorFlow XLA (Accelerated Linear Algebra): Compila modelos para execução eficiente em TPUs.

- JAX: Biblioteca do Google que usa TPUs para otimizar cálculos com diferenciação automática.

- PyTorch/XLA: Adaptação do PyTorch para suportar TPUs.

2. Apple Neural Engine (ANE)

- Core ML: Framework para otimizar modelos de IA para iPhones e Macs.

- Metal Performance Shaders (MPS): Biblioteca de GPU/NPU para computação de alto desempenho.

3. Huawei Ascend NPU

- MindSpore: Framework de deep learning otimizado para NPUs Ascend.

- TensorFlow e PyTorch (com adaptadores da Huawei).

4. Intel Movidius (VPU – Vision Processing Unit)

- OpenVINO: Ferramenta da Intel para otimizar e rodar modelos de IA em NPUs Movidius.

5. Qualcomm Hexagon DSP/NPU

- Qualcomm AI Engine + SNPE (Snapdragon Neural Processing Engine): Biblioteca para rodar modelos otimizados em Snapdragon NPUs.

Programação em NPUs – Como funciona?

A maioria dos modelos de aprendizado de máquina é treinada usando frameworks populares como TensorFlow, PyTorch ou ONNX, e depois convertida para um formato otimizado para execução em uma NPU.

O processo geralmente envolve três etapas:

- Treinar o modelo (usando CPU/GPU).

- Converter para um formato compatível com a NPU (usando um compilador específico).

- Executar e otimizar na NPU (usando bibliotecas especializadas).

Conclusão

È necessário usar bibliotecas específicas para aproveitar ao máximo o desempenho das NPUs. No entanto, muitos desses frameworks oferecem suporte para converter modelos treinados em TensorFlow, PyTorch e ONNX, tornando a transição mais fácil para desenvolvedores que já trabalham com IA.

Sê o primeiro